سئوی robots.txt ، مثالی بزرگ برای جستجوگرها: اگر دقت کرده باشید، فایل robots.txt معمولاً در شاخه های اصلی فایل های وب سایت شما وجود دارند. بگذارید همین ابتدا خیالتان را راحت کنم. این فایل مستقیماً بر رروی سئوی وب سایت شما تاثیر می گذارد. پس اگر تابحال به آن اهمیت نمیدادید، از این پس باید نگران صحت محتوای آن شوید. این فایل مشخص می کند که جستجوگرهایی مثل گوگل چگونه و به چه شکل چه دسترسی هایی به چه قسمت هایی از وب سایت شما داشته باشند. همانگونه که از نامش پیداست، این فایل ربات های موتورهای جستجوگر را هدایت می کند تا به آن چه شما مشخص کرده اید دستیابی داشته باشند. در این نوشته سعی بر آن داریم تا مشخص کنیم چطور این فایل می تواند به بهترین شکل تغییر یابد و تا آن جا که ممکن است به سئوی وب سایت شما و ایندکس محتوایتان کمک کند. با طراحی سایت تی اچ دیزاینر همراه باشید.

در آموزش سئوی robots.txt، مثالی بزرگ برای جستجوگرها خواهید آموخت:

- اشاره گوگل به سایت شما

- فایل robots.txt چه کاری انجام می دهد؟

- بهترین روش برای پیشگیری از مسدود شدن محتوا

- رابطه افزونه yoast با فایل robots

- محتوای فایل robots.txt در وردپرس

از این به بعد گوگل به سایت شما هم اشاره می کند

گوگل دیگر کودکی نیست که فقط به محتوای html سایت شما دقت کند و آن را در حالی که شما از دیگر تکنولوژی هایی مثل جاوا اسکریپت و … استفاده می کنید نادیده بگیرد و تمامی محتواهای تمام صفحات شما را بیرون بکشد. گوگل فقط به دستور شما صفحاتی مشخص را مورد دسترسی قرار می دهد. اگر به آن بگویید صفحاتی مثل بک اند وب سایتتان را ایندکس نکند، او به شما احترام می گذارد و این کار را انجام نمی دهد. بله، به واسطه فایل robots. این قضیه از الگوریتم پاندای گوگل شروع شد و به راحتی می توان به آن اشاره کرد که هرگز فایل های سی اس اس یا جاوا اسکریپت شما را مورد بررسی قرار ندهد. اگر از افزونه یوآست در سئوی وب سایت وردپرسی خود استفاده می کنید، پیشنهاد می کنیم به نوشته نحوه افزودن کلمه کلیدی و توضیحات متا در وردپرس نیز نگاهی بیاندازید.

فایل robots.txt دقیقاً چه کاری انجام می دهد؟

این فایل به روبات های جستجوگر یا کراولر آموزش می دهد که چگونه چه فایل هایی را کراول کند. در اصل این فایل چگونه خزیدن خزنده ها را به آن ها می گوید. البته در سایت های وردپرسی با هاست مخصوص وردپرس این فایل ها بسیار مختصر هستند. بطوریکه فقط به آن ها گفته شده به جز فایل های مدیریتی، تمام محتواهای سایت را کراول کنند. قالب اصلی این فایل به شکل زیر می باشد:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

مختصر بخواهیم بگوییم، این فایل به خزنده ها می گوید که چه قسمت هایی را اجازه دارند دنبال کنند و چه قسمت هایی را مجاز نیستند و اجازه ندارند که دنبال کنند. البته که این دستورالعمل ها می تواند بسیار بیشتر از این حرف ها باشد اما نباید جزء به جزء دستور در آن وارد کنیم. دستورات می بایست بصورت کلی و مختصر گفته شود.

بهترین روش برای پیشگیری از مسدود شدن محتوا

بهترین روش پیشگیری از مسدود کردن دسترسی به دایرکتوری های بک اند شما و دایرکتوری های غیرضروری دیگر برای سئو شما از طریق robots.txt است. اگردقت داشته باشید در وردپرس از نسخه 4 به بعد، مشخص شد که در فایل ربات این سیستم مدیریت محتوا دایرکتوری هایی مثل wp include یا plugins دیگر مورد ایندکس شدن قرار نمی گیرند.

البته باید این را در نظر داشت که برخی از قالب ها با تکتولوژی های مختلفی محتوا را نشان می دهند که اگر این ها مسدود شوند، روبات های گوگل یا هر موتور جستجوی دیگری نمی تواند آن را کرال کند. در همین راستا به گفته یکی از کارشناسان yoast که در حال حاضر برترین نرم افزار یا افزونه وردپرس در زمینه سئو را پیاده سازی کرده اند، این قضیه را طی یک تیکتی به کارشناسان وردپرس داده اند تا از این پس به وردپرس اجازه دهند تا مجوز کرال شدن فایل admin-ajax.php در فایل ربات به گوگل داده شود.

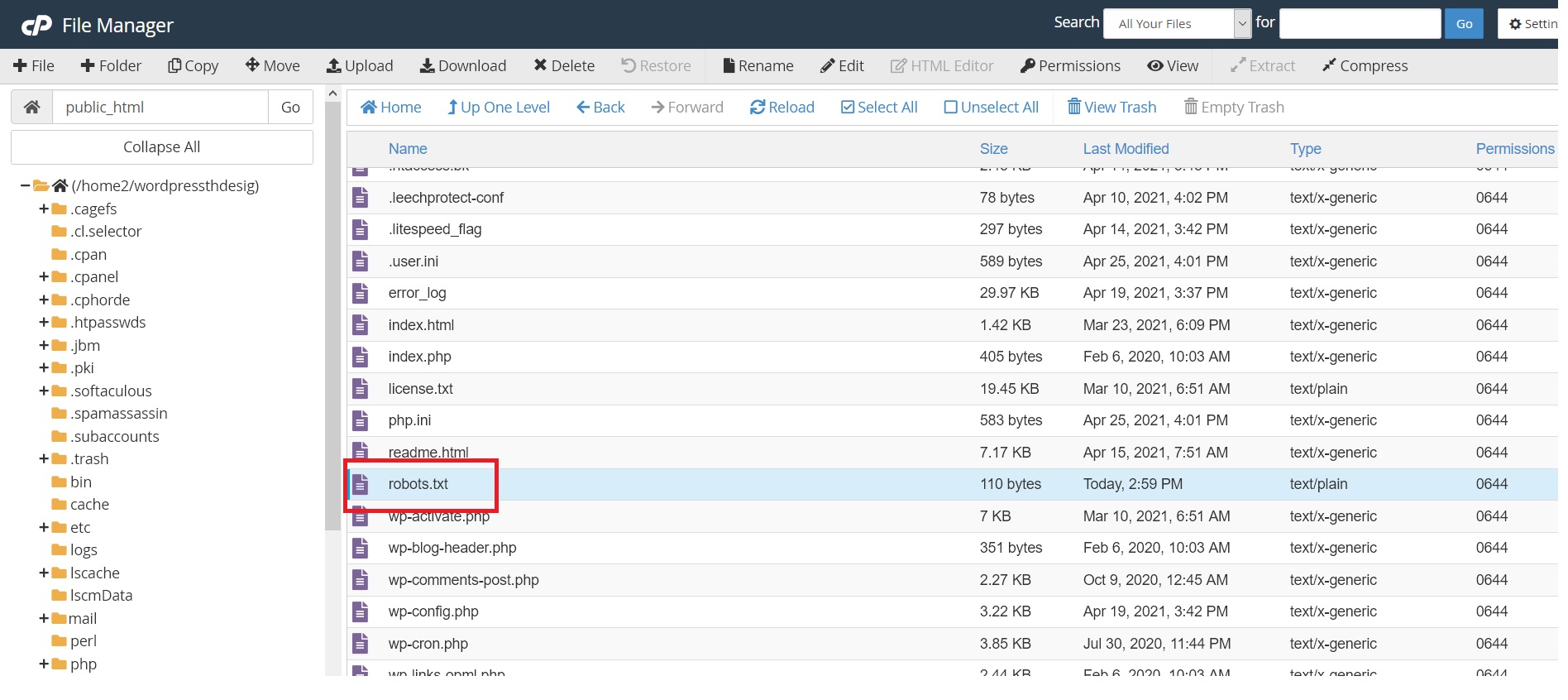

فایل robots.txt کجاست؟

سوالی که شاید برای شما هم پیش بیاید این است که این فایل در کجا قرار دارد. یا بهتر است بگوییم در کجا باید بدنبال این فایل بگردیم؟ پاسخ این سوال بسیار ساده است. این فایل در پوشه public_html هاست شما قرار دارد. دقت داشته باشید که اگر این فایل در هاست شما موجود نبود می توانید خودتان آن را ایجاد کنید.

دقت داشته باشید که این فایل حتماً باید با نام robots.txt باشد و تمام حروف انگلیسی آن باید کوچک باشد.

در استفاده از Robots.txt جوگیر نشوید

چیز دیگری است که بسیار مهم است به یاد داشته باشید: اگر از robots.txt سایت خود برای مسدود کردن URL استفاده کنید، موتورهای جستجو آن را خالی نمی کنند. این بدان معنی است که آنها نمیتوانند مقدار پیوند را در URL های مسدود شده توزیع کنند. بنابراین اگر یک ناحیه از سایت شما وجود داشته باشد که دارای پیوندهای زیادی با آن است، اما شما نباید در نتایج جستجو ظاهر شوید، از طریق robots.txt آن را مسدود نکنید، از meta tag robots با مقدار noindex استفاده کنید. این کار باعث می شود تا ربات های گوگل را به درستی به آن چه که می خواهید هدایت کنید. پس در نتیجه دقت داشه باشید که فایل Robots سایت شما یک مجوزنامه نیست که هر آن چه را که می خواهید و نمی خواهید به آن اضافه کنید.

yoast در رابطه با سئوی robots.txt چه می گوید؟

جالب است بدانید که یوآست که بهترین افزونه سئوی وردپرس را ارائه داده است، خود در سئوی robots.txt مخالف بلاک کردن بسیاری از مواردی است که در این فایل بصورت دیفالت بلاک می شوند. یکی از کارشاسان وب سایت یوآست پس از بررسی طراحی وب سایت تی اچ دیزاینر، می گوید: هم اکنون وب سایت های خود ما هیچ چیز را در فایل ربات وردپرس بلاک نمی کند. ما حتی ترجیح می دهیم تا دایرکتوری هایی مثل plugins یا includes کاملاً کرال شوند، زیر بسیاری از آن ها صفحات ای جکس یا جاوااسکریپتی دارند که نیاز است تا محتوایشان که به وردپرس شما مرتبط است را در دسترس ربات ها قرار دهند.

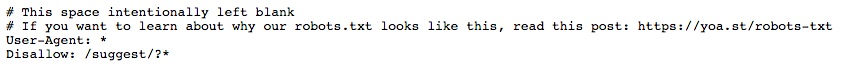

سئوی robots.txt

به تصویر فوق دقت کنید، واقعاً حتی برای خود بنده هم جالب است. این تصویری از فایل ربات وب سایت یوآست است. در این فایل طبق گفته خودشان هیچ چیز را بلاک نکرده اند و به جستجوگرها این اجازه را داده اند تا به همه چیز دسترسی داشته باشند. کارشاس یوآست می گوید، ما حتی دایرکتوری wp-admin را هم بلاک نمی کنیم.

سوال تکراری: آیا باید به سایت مپ در فایل ربات لینک دهیم؟

به شخصه از بنده در طول تمام سابقه کاری ام در رابطه با سئوی robots.txt این سوال را بسیار پرسیده اند و واقعاً سوالی تفکر برانگیز می باشد. به این دلیل که هر دو فایل sitemap.xml و robots.txt بطور مستقیم و تاثیرگذاری در سئو هستند و نباید به سادگی از آن ها گدشت. به شخصه پاسخ سوال را به این شکل می دهم که چه اشکالی دارد و فایل ربات به فایل نقشه هم اشاره ای شود؟ اگر سودی نداشته باشد، ضرری هم ندارد. اما کارشناس سئوی یوآست کاملاً برعکس، می گوید: دلیلی ندارد در این فایل به نقشه اشاره ای شود. نقشه سایت یا همان sitemap.xml فقط باید در وبمستر گوگل اضافه شود و در سایت شما وجود داشته باشد. نظر شما در این باره چیست؟

محتوای فایل robots.txt در وردپرس

سوالی که بسیار پرسیده می شود این است که بطور پیشفرض و استاندارد این فایل در یک سایت وردپرسی چه محتوایی می بایست داشته باشد. در وردپرس این فایل دارای محتوای زیر بصورت پیشفرض و استاندارد می باشد:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://dehosting.ir/sitemap.xml

user-agent در اینجا به معنی دسترسی کامل به خزنده ها می باشد. در ادامه disallow به معنای این است که مسیر ذکر شده را دنبال نکند و اجازه ای برای خزیدن نداشته باشد. در نهایت قسمت allow هم قسمتی است که اجازه می دهد خزنده ها آن ها را دنبال کنند. در قسمت سایت مپ هم می توانید آدرس سایت مپ خود را وارد کنید.

5 دیدگاه. Leave new

جالب بود

سلام ببخشید من اصلاً این فایلو ندارم چطوری باید بسازمش؟

درود بر شما، این فایل توسط افزونه های سئو مثل یوآست ساخته می شود. همچنین خودتان از طریق هاست نیز می توانید آن را ایجاد کنید.

سلام،

آیا این فایل حتماً باید وجود داشته باشه؟ چون من ندارمش!

درود بر شما،

بله وجود این فایل برای سئو بسیار مهم است و اگر آن را ندارید باید ایجاد کنید.